jeudi 5 décembre 2013

mardi 12 novembre 2013

Au revoir Cédric et merci pour tout !

Comme beaucoup le savent déjà, Cédric "Sid" Blancher nous a quitté lors d'un accident de parachutisme.

C'était un garçon formidable et c'est une grande perte. J'ai eu l'occasion de le rencontrer, comme beaucoup, par nos blogs ou dans des colloques et conférences.Parler ainsi de lui n'est pas si facile et j'ai donc choisi de partager avec vous un bon souvenir avec lui qui illustre ses qualités.

Il y a un mois environ, lors d'un déjeuner, Cédric était invité ainsi que d'autres convives. Parmi les autres invités, des blogueurs mais surtout, pour certain, sans lien aucun avec la SSI, la sécurité informatique ou encore le hacking.

J'ai dû partir dans les premiers, laissant les autres convives entre les mains de "Sid" tous en plein échange, discutant, riant...Et ça ne vous étonnera pas mais tous m'ont dit avoir passé un excellent moment et avoir rencontré quelqu'un d'une qualité rare. Et ce sont ces mêmes personnes qui m'ont averti ce week-end de la triste nouvelle et m'ont fait part de leur émotion.

De Cédric, je retiendrais ce moment : une rencontre suffisait pour être charmé, une rencontre et vous aviez un nouvel ami.

Mes pensées vont à sa famille et ses proches.

Quelques billets lui rendant hommage :

vendredi 8 novembre 2013

vendredi 27 septembre 2013

Réagir à l'attaque informatique : quelle complexité ?

|

| Source : carnal0wnage.attackresearch.com |

L'inspiration de cet article est venu ailleurs alors que l'on m'interrogeait sur la signification du terme "APT" pour "Advanced Persistant Threat" et sa portée. L'acronyme, un peu comme "cyber", a fini par devenir un terme usuel dont le sens n'est pas très clair. On entend parfois n'importe quoi à son sujet comme l'individu qui s'exclame : "ah, j'ai reçu un pdf ...j'ai une APT"...

En premier lieu, il ne s'agit pas d'une maladie mais d'une tentative de synthèse pour un phénomène complexe. L'idée est de représenter les caractéristiques des attaques informatiques "modernes" en insistant sur leurs facettes :

- "Avancées" comme relativement complexes parfois dans leurs aspects techniques, fréquemment dans l'orchestration des actions et la malignité des techniques. On peut également y entendre la prise de contrôle "avancée" d'un réseau avec le gain de privilèges très élevés.

- "Persistantes" car bien souvent, il s'agit, une fois entrée, de durer et de persister en dépit des efforts des responsables légitimes pour vous déloger. La notion de persistance illustre aussi bien gagner le contrôle durablement et en profondeur d'une machine que de l'ensemble d'un réseau.

Pour ma part, c'est ainsi que je le comprends. Effectivement, bien souvent, et comme le rappelle les éléments publics de certaines affaires célèbres, "Bercy" ou "Areva", tout cela commence bien souvent par un acte individuel et anonyme qu'est l'ouverture d'un fichier délibérément piégé et rendu attractif.

Toutefois, pour le profane, le praticien SSI apparaît parfois un peu austère voire légèrement autiste. En bref, il n'est pas illogique de ne pas comprendre ce qu'il en est. En revanche, il est toujours intéressant de savoir quels en sont les enjeux et les solutions trouvées.

Il existe de nombreux soucis dans la gestion de telles attaques. Aujourd'hui, nous en retiendrons principalement un : la détection. Nous pourrons évoquer plus tard, l'assainissement ou la reconstruction ou encore l'amélioration post-incident.

La détection recouvre en réalité deux actions bien distinctes. La première serait l'alerte, c'est à dire la découverte d'une infection initiale ou encore le sentiment que "ça colle plus" ou que "Houston, on a un problème"...La seconde consiste à mesurer le profondeur du problème et à détecter l'ampleur de celui-ci.

L'alerte dépend de nombreux facteurs. Une bonne équipe SSI peut disposer de moyens de recueil d'infos et d'analyse permettant de matérialiser de tels problèmes. Avec de la chance, l'outil de l'attaque pourra faire réagir un ou plusieurs des outils de sécurité que vous pourriez avoir (proxy, IDS, firewall, antivirus).

Par exemple, si le composant malveillant contacte une adresse connue à l'extérieur, celle-ci peut être repérée grâce à l'usage de liste noire dans un proxy. Ou encore si le motif des flux est repérable, il pourra être détecté par une sonde de détection d'intrusion. Parfois, c'est le comportement de vos équipements qui sera détecté par un autre acteur : "Allo, M. RSSI ? Oui... ? Je suis administrateur sécurité dans la société machin et l'un de vos serveurs est décidément très motivé pour scanner mes ports et trouver des failles !".

Mesurer l'ampleur de l'attaque dépend de plusieurs facteurs. Mais l'idée principale est les acteurs en présence ne disposent pas toujours d'une représentation des systèmes à l'état "sain". Autrement dit, c'est un peu chercher la fameuse aiguille dans la non moins fameuse botte de foin ! Prenons un exemple courant : vous rencontrez un homme très pâle : est-il malade ? est-il doté d'une telle constitution ? A-t-il mangé quelque chose de périmé ? Ou bien ressort-il d'une longue maladie ?

C'est un peu la même idée en fait car la comparaison avec un état sain nécessite de d'abord connaitre cet état : la préparation, et c'est évident, à subir de telles attaques est donc indispensable. Par exemple, lorsque l'analyse détient la liste des comptes dans un annuaire d'entreprise ou encore la liste des utilisateurs d'un serveur, comment pourra-t-il savoir si certains comptes sont illégitimes ?

Ou bien encore, tel programme est-il légitime ? Tel exécutable est-il bien celui qu'il parait être ?

Les professionnels de la SSI ont bien fini par comprendre le problème car l'alerte et la détection de l'ampleur ont un point commun : il faut savoir ce que l'on cherche. Une des réponses a donc été les indicateurs de compromission (IoC) qui se traduit bien en anglais : Indicators of Compromise.

L'objectif est de fournir tant un moyen d'alertes que de mesure de l'ampleur en définissant, par référence à un cas connu, les modalités ou les "symptômes" de l'infection. Le rapport Mandiant et la société du même nom ont d'ailleurs développé un outil comprenant un format (un langage commun) permettant de lire et de créer de tels indicateurs.

Dans l'exemple cité en source, il est possible de télécharger la liste des IOCs de l'attaque en question et de les parcourir afin de définir des modalités adaptées de recherche de ces caractéristiques. Notez aussi l'outil Yara qui a plusieurs modules dont l'objet est d'intégrer plusieurs types d'IOC (des séquences de caractères par exemple) pour les recherchez de manière systématique sur des fichiers et des arborescences. On peut même y ajouter des règles en demandant de rechercher telle règle OU telle autre ou bien celle-ci ET celle-là.

L'originalité et l'utilité des IOC est la multiplicité des informations et la combinaison de celles-ci que l'on peut faire. Par exemple, dans le cas cité ci-dessous, on trouve aussi bien : des empreintes de fichiers, des adresses IP en destination (utilisées peut-être pour l'exfiltration de données ou l'envoi de commandes) ou encore des chaines de caractères spécifiques.

Celles-ci sont combinées pour tenir compte des versions et évolutions du malware. C'est typiquement l'usage du "OU" : la diversité des empreintes uniques (hash) de fichiers ne limite par la possibilité de détecter telle ou telle version.

Les IOCs ne sont pas la solution parfaite mais adossées à la réactivité de la communauté, elles constituent une réponse intéressante à ces problématiques d'APT que nous venons d'évoquer. Nul doute que d'autres idées viendront afin de progresser dans le traitement de ces sujets complexe mais au coeur de l'actualité en sécurité !

Source :

Libellés :

LIO - LID,

Sécurité - Organisationnelle,

Sécurité - Technique

jeudi 19 septembre 2013

Irrévérencieusement vôtre !

|

| Source : cybersecurite.fr |

Soyons francs : cet article risque de ne pas plaire. Il faut bien parfois. Ce billet m'a été inspiré par un constat un beau matin alors que, comme chaque matin, je m'astreignais à dépiler la veille quotidienne. Or, ce fameux matin, en matière cyber, demeura la furieuse impression que plus rien n'était nouveau et que d'un article à l'autre, on réchauffait les mêmes vieilles idées.

Prenons cet article : son auteur évoque rapidement Snowden, la NSA, Vupen et l'achat de vulnérabilités et ce qui s'annonce comme des arguties juridiques sans fin. En quelques mots - et je suis persuadé que l'auteur peut, a déjà fait et fera mieux - c'est réchauffé, ennuyeux et vaguement faux.

Réchauffé car l'affaire Snowden a déjà été analysé de manière pertinente et moins et qu'il faudrait creuser de manière innovante pour en tirer tout ce qui pourrait être dit. Ennuyeux car on ne cesse de parler, voire de critiquer ou d'envier Vupen, qui fait un boulot techniquement remarquable et développe son modèle de manière ouverte (il suffit d'aller sur le site)...Faux car Snowden et les questions de NSA sont mélangés avec la SSI, la lutte informatique et les stratégiques ou tactiques en matière d'usage offensif de l'information.

De même, me sentant vaguement coupable de n'avoir pas assisté au 1er Symposium Académique national de recherche en cyberdéfense, l'allié Si-vis en a fait un agréable compte-rendu immédiatement rassurant : on n'a pas encore décroché la lune et je n'ai rien raté.

Les derniers ouvrages ou travaux qui m'ont été donné de lire présentent des dérives similaires. Les seules différences avec les bêtises que j'écrivais lors de mes études sont les références et certains événements qui, alors ne s'étaient pas encore produits. Le "cybercommand" fait encore recette sans parler de la RMA ou encore des stratégies cyber ou des tactiques "trucs"...

Ce constat s'explique par quelques raisons - qui ne sont que ma vision - : tout d'abord, ce domaine, qu'il soit abordé sous l'angle technique, sécurité informatique ou encore "opérationnel" demeure encore très secret. Que la NSA soit un sujet à la mode ne doit pas nous faire oublier que, selon M. Merchet, on aurait renforcé la protection du secret en France sur ces questions. Ce premier point explique donc que les commentateurs et analystes finissent par être "secs" toujours selon l'adage que ceux qui savent, en ces domaines, ne parleront que peu.

L'autre problème serait, pour moi, la méthode : il n'est pas possible de progresser sur ces sujets sans réfléchir de manière différente et sans se livrer à un travail de recherche complexe, long et surtout innovant. Le sujet présente une composante technique forte et ne pas s'y attarder est une "faute logique".

Tout n'est pas perdu cependant et puis conclure un tel article sans offrir des solutions serait peu courtois. Aussi, sur les questions de renseignement par exemple ou sur toutes activités dont le poids du secret est importante, les travaux de Zone d'intérêt, allié au grand mérite, me semblent le chemin à prendre ainsi qu'une source d'inspiration innovante.

N'oublions pas aussi les travaux de la chaire Cyberdéfense que j'évoquais récemment. A première vue, la notion de "chaire" ou encore l'association avec Saint-Cyr peut faire frémir. Et je dois bien avouer que je n'ai pas lu tous les articles. Mais j'ai participé à certains travaux et un des avantages est qu'aucune question n'est écartée et qu'une forte discipline scientifique est exigée.

Le second point clé est l'association des compétences : remarquez par exemple l'article rédigé par M. Paget que l'on connait plus volontiers pour ses travaux chez un éditeur anti-virus et qui a accepté de travailler sur l'hacktivisme.

Enfin, à mon sens, dans la catégorie des "exemples" figurent également bon nombre de blogs de nature plus techniques. S'il est vrai que les aspects techniques continuent de m'intéresser, je suis régulièrement surpris par leur capacité à innover, à se poser des défis et même parfois à oser poser un orteil sur le terrain réservé des analyses de nature plus "politique" ou "stratégiques"...

Concluons ici : il est temps d'innover et de rechercher d'autres manières de réfléchir et de proposer des idées. Limiter sa recherche et sa réflexion à un unique domaine est, en matière "cyber", le plus sur moyen de scléroser sa pensée.

Vous voulez penser "cyber", penser comme un hacker et piratez-vous le cerveau :)

Sources : dans le texte

mercredi 18 septembre 2013

Chaire de Cybersécurité/Cyberdéfense - St Cyr & Sogeti/thales

Retrouvez en ligne les articles produits par la chaire cyberdéfense ainsi que ceux issus du colloque consacré à la Chine.

Notez en particulier la profusion d'articles ou d'interviews de personnalités, chercheurs ou autres, étrangers. Cela permet notamment d'avoir un aperçu de la manière dont ils approchent les sujets.

Bonne lecture !

Source : dans le texte

Libellés :

Chine,

Colloque/séminaire,

Cyberwarfare,

LIO - LID

lundi 26 août 2013

La sécurité de l’information est-elle un échec ? Que faire alors ? Ecce homo

|

| Source : http://www.scoop.it |

http://alliancegeostrategique.org/2013/08/27/la-securite-de-linformation-est-elle-un-echec-que-faire-alors-ecce-homo/

A toutes fins utiles, vous trouverez au début de l'article un lien vers l'ensemble des parutions précédentes.

Ce travail vient conclure une réflexion de presque 2 ans puisque le premier article avait été publié en octobre 2011. Il a été l'occasion de prendre un temps de recul alors que l'actualité accapare souvent les acteurs du domaine en les obligeant à réagir.

J'espère que vous y trouverez des idées intéressantes et peut-être même susceptible de vous aider dans votre quotidien.

La conclusion - remettre l'humain au centre - peut vous surprendre mais dans ces temps de crise et de questionnements sur nos modèles de société, il n'est pas délirant de prétendre trouver en cela une réponse.

Source : dans le texte

Libellés :

AGS,

LIO - LID,

Sécurité - Organisationnelle,

Sécurité - Technique,

Stratégie

Asia - the cybersecurity battleground : Audition de James Lewis

Découvrant grâce à E-Conflict, une des dernières parutions du CSIS, j'ai eu le plaisir de lire un texte agréable, issu d'une audition, bien pesé et apportant quelques idées nouvelles. En voici un florilège...

Tout d'abord, l'on doit ce texte à l'intervention de James Lewis s'exprimant sur le sujet de l'état de l'environnement "cybersécurité" en Asie. Notons qu'il s'agit d'un texte synthétique : tout lecteur qui rechercherait les preuves des assertions de M. Lewis serait déçu. Il s'agit plutôt d'un condensé de ses opinions, acquises pendant d'autres travaux. Une rapide recherche vous montrera que James Lewis est un habitué du sujet, plusieurs fois cité dans ce blog.

Voici les idées que l'on peut garder :

- La volonté des protagonistes (USA, Chine et autres) de limiter la portée de leurs actions en restant volontairement sous ce qui pourrait déclencher une guerre ;

- "Spying is not warfare " : cette citation car bien souvent, l'impression demeure que des faits d'espionnage sont cités à l'appui des questions de "cyberguerre" ;

- les actions d'espionnage en particulier chinoises auraient un impact régional décisif et auraient tendance à raidir les positions des voisins. En particulier, et c'est assez drôle, l'orateur qualifie les activités chinoises de "noisy", donc bruyantes et facile à détecter ;

N'étant pas spécialiste du domaine, on ne peut que constater que de nombreux cas sont rapportés et attribués ainsi. Pourtant, la difficulté de l'attribution au-delà de tout doute reste à ce jour très difficile ;

- il confirme également le déficit criant en matière de sécurité de la Chine, utilisateur immodéré de matériel contrefait et donc proie facile. Souvent évoqué, ce thème se fait plus rare ces derniers temps mais demeure vrai et ce, pour n'importe qui ! L'attaque n'est pas assimilable à la défense...

- Selon lui, l'activité d'espionnage, en particulier à vocation économique, n'est pas une démarche unifiée. L'impression qui se dégage est que si l'espionnage n'est pas systématiquement encouragée par les plus hautes autorités, celles-ci ne disposent plus vraiment des moyens de l'arrêter. D'une part, celui-ci serait désormais trop imbriqué avec la croissance économique et constitue un formidable moyen de gains. D'autre part, les entités responsables de ces acteurs sont parfois bien appuyées et elle-même "fortes" : à défaut d'une politique intelligente, une simple décision ne suffira pas à enrayer le système. D'une certaine manière, cela rappelle la difficulté à lutter contre la corruption ;

- le développement des normes et codes de conduite appliqués à la question des attaques informatiques est selon lui un facteur majeur dans l'avenir. L'approche russe et chinoise (Code of Conduct for Cyberspace) s'oppose encore aux approches développées par les USA et ses alliés. Il demeure cependant nécessaire d'utiliser autant que nécessaire les outils diplomatiques plutôt que la force ou la coercition qui contribueront à créer des situations sans intérêt pour toutes les parties.

En bref, un texte intéressant qui semble bien informé et qui propose une vision éclairée de la situation. On peut y trouver à redire mais l'ensemble demeure attractif notamment pour une certaine prudence dans le ton et les propos. N'hésitez pas à le lire pour y trouver ce qui m'aura échappé.

Source : dans le texte

Libellés :

Chine,

Cyberwarfare - USA,

Défense,

Diplomatie,

ONU,

Russie

vendredi 12 juillet 2013

Stratégie du "Big 7" : quelle efficacité ?

Nous, passionnés voire professionnels de SSI - ne partez pas les autres, c'était juste pour rire -, et plus généralement tout personnel ou toute entité ayant à traiter du risque se pose nécessairement la question de l'allocation des ressources.

De multiples facteurs ont en effet un impact sur la disponibilité des ressources que ce soit dans des entités publiques - à qui l'on réclame sans cesse de moins dépenser - que des entités privées - qui subissent une santé économique précaire à la suite d'une crise d'envergure.

A cela s'ajoute une complexité inhérente au métier "SSI" qui est de devoir gérer la précarité de la confiance. En deux mots, il s'agit de s'assurer que des fonctions ou des services critiques (compte en banques, impôts, paies, systèmes industriels...) mais confiées au moins pour partie à des outils informatiques présentent un certain niveau de confiance.

L'analyse de risque puis sa gestion sont alors les outils privilégiés pour les acteurs et décideurs. Il s'agit de déterminer ce qui doit être protégé et contre quoi (en simplifiant!). Les ressources peuvent alors être allouées en fonction des risques qu'il faut ramener à un niveau acceptable, pour s'assurer contre ces risques (les transférer). On peut aussi n'affecter aucune ressource à un risque donné : soit on "prend" le risque pour utiliser une expression familière mais on peut également décider de supprimer l'activité génératrice du risque.

Tout cela n'est pas que du ressort du praticien SSI : celui-ci est à l'aise pour "matérialiser" les risques, les rendre crédibles et compréhensibles à ses décideurs. Mais la décision de prendre ou refuser un risque est par exemple du ressort d'un acteur à qui a été confié une responsabilité importante pour la vie de l'entreprise.

Certains risques sont plus facilement visibles que d'autres et les limiter pas nécessairement très complexe. La continuité d'activité n'est ainsi pas un métier évident mais les outils pour créer une capacité de résilience sont relativement nombreux. Une entité qui, par exemple, externalise tout ou partie de ses systèmes peut choisir son prestataire en fonction de sa capacité à lui offrir des multiples data-center éloignés. Les "cluster" et l'ensemble des équipements offrant des fonctionnalités de type "actif-actif" ou "actif-passif" sont autant d'exemples.

D'autres risques sont plus complexes à gérer comme la protection des informations de valeur pour l'entité (personnelles, contrats, listes de clients, développements..) ou s'assurer que le réseau ne soit pas envahi par des intrus.

L'allocation des ressources intervient alors afin de mettre en oeuvre la démarche nécessaire pour gérer ces risques. Il existe pour cela plusieurs méthodes dont une découverte aujourd'hui durant la veille quotidienne. L'idée est de contrôler les "Big 7" dans un contexte de ressources contraints : il s'agit notamment dans l'idée formulée par l'auteur de l'article de s'attacher à mettre à jour les logiciels les plus connus et utilisés - à la fois par l'utilisateur mais aussi par les "pirates" -.

En s'inspirant des analyses des attaques récentes, l'auteur produit un modèle qui limite l'usage des ressources affectées à ce risque spécifique en contrôlant notamment ces 7 applications (le navigateur, Java, Acrobat Reader, Word, Excel, Power Point, Outlook). Il s'agit d'une part de s'assurer qu'ils soient fonctionnels et à jour et d'autre part de définir des profils d'usage à partir desquels on pourra identifier des divergences. Ces "déviances" du profil normal sont alors susceptibles de représenter des attaques et de déclencher une intervention.

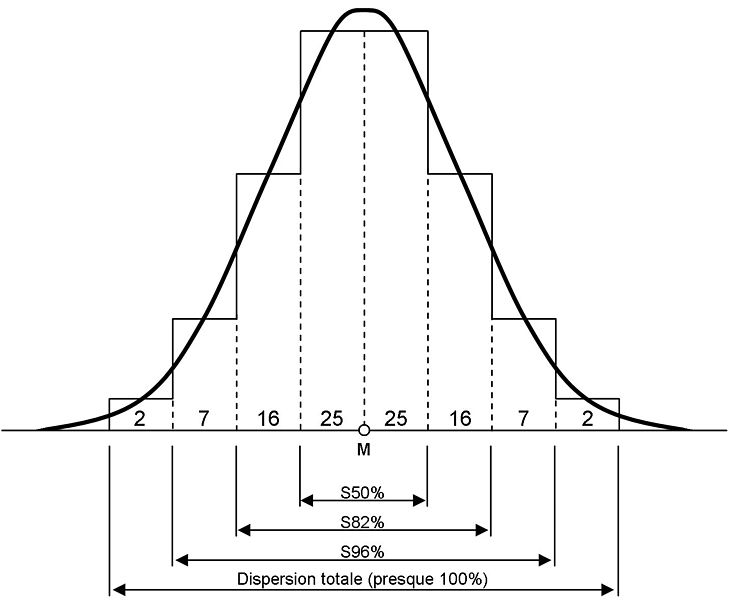

L'idée semble excellente et en y réfléchissant un peu, on s'aperçoit qu'il s'agit d'une gestion "gaussienne" des risques. Si l'on considère la "population", c'est à dire le nombre d'attaques et les méthodes d'attaques, il s'ensuit - si l'on suit la logique - que le nombre d'attaques est très élevé (et donc la chance qu'elles se produisent) dés lors que vous "Big 7" ne sont pas ou mal gérés...

Avant de continuer, je vous invite à relire ces quelques applications des probabilités à la sécurité, la défense ou même la guerre...bonnes ou pas. Comme vous vous en doutez, cela n'a pas été sans effet sur cet article. C'est fait ? Continuons...

La problématique d'une gestion de ce type, qui conditionne l'allocation des ressources aux risques considérés comme "majeurs" est effectivement d'écarter les cas "limites" ou "extrêmes". En soi, cela n'est pas dommageable car on peut considérer que le fameux "Cygne noir" que vous avez pu lire dans les articles précédents ne restera que théorique.

Re-basculons un instant dans la SSI et considérons quelques faits supplémentaires :

- tout attaquant informatique est opportuniste. L'attaque peut survenir car la ressource qu'il acquiert aura une valeur tant qu'il trouve une vulnérabilité. La surface d'attaque est donc réduite et proche des "Big 7" et le temps qu'il consacrera sera limité.

- tout attaque ciblée n'est pas moins opportuniste ! La surface d'attaque est immense puisque chaque possibilité sera exploitée et il n'y a que peu de contrainte de temps. Dans ce genre de cas, on quitte le cas gaussien car la probabilité que soit utilisée les attaques "extrêmes" augmente de manière importante.

En bref, la stratégie des "Big 7" est efficace contre les attaques "moyennes" ou "classiques" mais ne le saura pas contre un attaquant motivé disposant de temps et/ou de ressources. Cela ne restreint pas la liste aux Etats car il me semble crédible d'y ajouter des organisations criminelles.

Il est également possible de considérer qu'une telle stratégie serait efficace dans le cas d'une entité pour qui la répartition des risques gaussienne est réelle et qui a principalement affaires à des risques moyens. Peu informatisée, ne gérant pas d'activités au profit de l'état, sans lien avec des activités financières...sont des critères qui peuvent qualifier une telle organisation.

Pour les autres, la répartition des risques me parait tout à fait différente car le "cygne noir" informatique a une portée réelle. De plus, et contrairement à d'autres secteurs, ce fameux événement très rare mais à très fort impact s'est, en quelque sorte, déjà produit. Des attaques de grande envergure ont eu lieu contre des organisations dont la sécurité apparaissait comme élevée.

Une telle méthode des risques parait donc limitée voire insuffisante. Une méthode alternative, comprenant la problématique d'allocation des ressources pourrait être :

- De définir des ressources liées à l'existence même de l'entité et d'adopter différentes "zones de risques" en fonction de l'impact potentiel sur l'activité ;

- Appliquer une forme de segmentation des activités, des personnels et des informations en fonction de ces "zones de risque"...L'objectif est de limiter l'inter-dépendance avec des zones de risques inférieurs par divers moyens d'organisations ou technique ;

- L'allocation des ressources peut alors être réalisée en fonction des impacts. Un avantage est né de cette répartition : les profils de risque de chaque "zone" est cohérent et il est probable que les ressources seront mieux employées que disséminées car elles pallieront moins à une multitude de risque très différents mais à des risques de nature proches.

En conclusion, le "Big 7" est une stratégie intéressante mais pas toujours adaptée. Intéressante au début car se fondant sur une approche rationnelle, il faut prendre en compte les contraintes du modèle sous-jacent. Le modèle alternatif n'est pas nécessairement meilleur mais à force d'inventer, nous produirons bien quelque chose !

Source : dans le texte

Libellés :

SCADA,

Sécurité - Organisationnelle,

Sécurité - Technique,

Stratégie

lundi 1 juillet 2013

L'illusion du mieux où comment Snowden va rendre votre vie plus difficile !

|

| Source : Gizmodo |

L'affaire PRISM, les débats sur la charmante personnalité de celui qui en a révélé les grandes lignes génèrent de nombreuses réflexions. Certaines sont percutantes, d'autres moins. Dans les très bonnes, j'ai trouvé la lecture des analyses du Jester rafraîchissante à défaut de la partager entièrement. En français et tout aussi intéressante, je vous conseillerais celle-ci.

Tout cela est bel et bon et fait réagir de nombreux analyses et autres publicateurs (un mix entre ceux qui publient et les prédicateurs) enfiévrés au sujet de la vie privée, de la surveillance de masse ou encore du renseignement et de son efficacité. Si, une fois encore, la virulence des propos est omniprésente ainsi qu'une bonne dose d'opportunisme ou d'approximation, cela m'a surtout inspiré quelques réflexions liées à la sécurité.

En premier lieu, il n'est un secret pour personne que le fameux "facteur humain" est au coeur de l'histoire. La formulation même, franchement technocrate, explique en partie pourquoi ce sujet échappe en partie - pour ne pas dire totalement - aux praticiens de la sécurité. Et il est bien difficile de leur en imputer la responsabilité !

En effet, l'expert ou le spécialiste en SSI connait le problème et sa dangerosité potentielle. En revanche, le traiter requiert des "outils" autres et un environnement relativement complexe à mettre en oeuvre. N'hésitez pas à relire la série d'article sur la SSI co-rédigé avec l'Alliance Géostratégique et en particulier celui se consacrant aux aspects humains.

Visiblement, ce sujet n'est pas nouveau pour votre serviteur puisqu'il vous proposait ces quelques réflexions sur la nécessité de changer de vision à propos du problème situé entre la chaise et le clavier. L'idée globale est que le niveau de sécurité n'augmentera pas tant que l'utilisateur ne sera considéré que comme un problème.

En ce qui me concerne, j'ai tendance à considérer qu'il existe une telle "imbrication" entre les salariés et le travail qu'il n'est pas possible de générer un niveau de sécurité sans s'appuyer sur ceux-ci...Le meilleur exemple est celui des comportements déviants générés lorsque les contraintes sont trop pressantes. On pourrait citer aussi la capacité de l'utilisateur à repérer les failles de son environnement immédiat et les signaler...ou pas.

Bref, après Bradley Manning, le cas Snowden n'est pas bon pour nous ! D'une part, cela illustre une forme d'impuissance de la sécurité au moins sur la gestion de l'humain. Vous me répondrez que Snowden est peut-être notre "cygne noir" (cf. également un autre blog allié). Après tout, c'est peut-être bien le cas !

Mais quoi qu'il en soit, il est à craindre que ces événements ne renforcent pas la confiance mutuelle entre les entreprises et leurs salariés. Pire encore, on pourrait craindre la mise en place d'un cercle vicieux qui nuirait de manière grave à la sécurité.

Si par exemple, une entreprise prenait "peur" d'un éventuel futur Snowden et adoptait, de manière arbitraire, des mesures de confinement plus importantes des informations. Celles-ci, se traduisant par des mesures contraignantes et vécues comme agressives, les salariés n'auront alors aucune envie de s'attacher à leur entité et d'y apporter une forme de fidélité : il est à craindre que la sécurité baisse ou soit contournée.

Nous ne saurions mieux conseiller les organisations de faire preuve d'une forme d'innovation managériale bienvenue afin de profiter de l'exemple - car autant le faire - pour renouveller les pratiques de sensibilisation et de de gestion de l'information en matière de SSI.

Comme quoi Snowden nous aura fait du mal à tous :D - pure provocation gratuite !

Source :

dans le text

Libellés :

NSA,

Sécurité - Organisationnelle,

Sécurité - Technique,

Stratégie

vendredi 28 juin 2013

Café Stratégique - Venez rencontrer vos blogueurs préférés - Jeudi 4 Juillet 2013 !

Vous nous lisez, vous nous connaissez par le web...Pourquoi ne pas venir nous rencontrer pour ce dernier café avant l'été afin d'échanger de manière informelle ?

dimanche 9 juin 2013

CyCon vs. SSTIC ? Sortir des oppositions...

|

| Mon invention : ne pas rire ! |

La semaine dernière se déroulaient deux évènements importants pour tout acteur un tant soit peu concerné par les questions de lutte informatique ou de sécurité des systèmes d'informations.

D'une part, le CCD COE organisait la CyCon, conférence dédiée aux questions doctrinales et stratégiques liées aux "cyberconflits". Celle-ci se déroulait à Tallin, en Estonie où se trouve le centre. Pour mémoire, le CCD COE est un centre de réflexion consacrée aux questions de lutte informatique qui entretient des liens privilégiés avec l'OTAN.

D'autre part, avait lieu le SSTIC, évènement de premier plan dans le milieu de la SSI française et qui existe depuis maintenant 11 ans. Pour mieux marquer l'éloignement, celui-ci avait lieu à Rennes qui rassemble, il est vrai de multiples entités "télécom" et qui tient une place important en matière de rayonnement SSI. Si le sujet vous intéresse, d'autres conférences parisiennes comme NSC ou encore la NDH ont lieu désormais depuis quelques temps et s'avèrent de très bon niveau.

Ayant eu la chance de participer au SSTIC durant ces 3 jours, j'ai pu avoir quelques échos au sujet de la CyCon. Pour ceux qui s'intéresseraient à ces conférences, l'excellent blog n0secure s'est fait un devoir de rendre compte des différentes conférences et des conclusions majeures.

Or, il suffit de comparer le compte-rendu de Cycon signalé ci-dessous ou encore son programme avec par exemple la dernière conférence du SSTIC pour constater ce qui semble, il est vrai, un profond fossé (pour dire le moins) !

D'un côté, la croyance dans les dialogues "cyber" rencontre peu d'adhésion de la part des experts techniques assistant au SSTIC. De l'autre côté, la vision "technique" des décideurs, stratèges et militaires semble bien différente du niveau d'expertise atteinte par les spécialistes en sécurité comme en témoigne les sujets que l'on peut découvre dans le "technical track" de la CyCon...

Avant que l'on oppose l'argument de la différence SSI/LID, je tiens à rappeler car la plupart des perspectives prises par les présentateurs au SSTIC étaient clairement offensives...Il s'agissait moins de défendre que de comprendre les attaques et en dessiner les chemins.

Autrement dit, et hors toute planification militaire, sécuritaire, technique ou tactique, la probabilité que les auteurs des futures attaques et de leurs aspects techniques se rencontrent lors de ces conférences techniques me parait très forte. De plus, il me semble impossible de créer des capacités de cyber-défense, qu'elles soient offensives ou défensives sans une base d'experts chevronnés, une problématique dont l'ampleur a été rappelé plusieurs fois et notamment dans le livre blanc.

Par ailleurs,considérons un instant qu'il soit nécessaire de développer des capacités de lutte informatique offensives et défensives qui dépassent largement le cadre plus classique de la sécurité informatique ou de la sécurité de l'information : cela signifie donc qu'il est plus que probable que nous soyons attaqués par ce biais d'une part mais également que nos autorités estiment qu'il est nécessaire de préparer des plans ou des modèles d'attaques...

Cette hypothèse étant posée - et elle est jugée préoccupante par le dernier livre blanc - il est donc absolument nécessaire que les modèles d'attaques et de défense se basent sur une information technique à jour, intègre et complète. Or, cette dichotomie croissante que je crois percevoir entre les tenants d'une approche stratégique et ceux qui préfèrent une vision d'expertise technique me semble le meilleur moyen de ne pas y arriver.

Rappelons également un fait simple : les attaques informatiques, même d'envergure, existaient bien avant que les décideurs politiques ou militaires n'en perçoivent la portée stratégique et décident de l'utiliser. Autrement dit, toute stratégique, tactique ou volonté liée à la défense ou à l'action offensive en matière informatique ou "cyber" ne pourra que se reposer sur la matière technique en premier lieu.

Il semble donc que pour y être efficace, le cheminement soit d'abord vers les approches techniques afin d'en comprendre la complexité pour ensuite les conjuguer aux besoins stratégiques de la défense. Et non pas l'inverse...

Concluons donc ainsi : il me semble aujourd'hui percevoir un écart croissant entre les professionnels de ces deux mondes que nous évoquons ici. A mon sens, un rapprochement semble nécessaire afin que les "plans" des uns ne soient pas bâtis sans lien avec la réalité des autres. Selon mon opinion, ce rapprochement a plus de sens, aujourd'hui et dans un premier temps, des stratèges vers les techniciens.

Pourquoi ce "sens" me demanderez-vous ? Tout simplement car la portée "stratégique" d'une attaque informatique n'implique pas nécessairement l'usage d'outils hyper-spécifiques (parfois si, bien sur) et l'expérience ou "l'antériorité" en matière d'attaques informatiques se trouve du côté de l'expertise technique. Ne pas s'y résoudre serait prendre le risque de se déconnecter de la réalité tout en n'oubliant pas que nous avons un certain retard en la matière.

Pourquoi ce "sens" me demanderez-vous ? Tout simplement car la portée "stratégique" d'une attaque informatique n'implique pas nécessairement l'usage d'outils hyper-spécifiques (parfois si, bien sur) et l'expérience ou "l'antériorité" en matière d'attaques informatiques se trouve du côté de l'expertise technique. Ne pas s'y résoudre serait prendre le risque de se déconnecter de la réalité tout en n'oubliant pas que nous avons un certain retard en la matière.

Pour terminer cet article, il me parait nécessaire de rappeler que la perception que nous pouvons avoir de cette distance croissante entre les mondes est liée à la publication de nombreux articles par des auteurs qui n'ont pas toujours une grande expérience du milieu ou encore des actions opérationnelles. Au contraire, les responsables de notre défense et de notre sécurité sont au contraire astreints à une discrétion de bon aloi qui ne permet pas nécessairement de mesurer leur positionnement : peut-être sont-ils épargnés par la tendance décrite ici...Mais cela n'empêche pas d'écrire et de réfléchir "à haute voix" !

Source :

dans le texte

Libellés :

Colloque/séminaire,

Cyberwarfare,

OTAN,

Sécurité - Organisationnelle,

Sécurité - Technique

Pays/territoire :

France

mercredi 29 mai 2013

On attaque ? A vos ordres, mon général, c'est quand vous voulez !

|

| Source : Wired.com |

Il semblerait que tout soit prêt pour "y aller" pour jargonner un peu. Qu'est-ce qui est prêt me direz-vous ? Et bien, l'environnement technico-opérationnel nécessaire aux lancements d'attaques informatique en parallèle aux opérations "classiques" et ce de manière fortement automatisée.

Mais que raconte-t-il songez-vous ? Hier encore, il affirmait le contraire ! Certes mais j'ai tendance à penser que - si bien réelle est cette tendance - que la multiplication des attaques informatiques qui deviendraient alors un "simple" outil militaire pourrait conduire à des tendances dommageables.

Quelle est cette tendance ? Elle se matérialise par la concomitance de 3 projets qui permettent de construire un système permettant aux décideurs américains de lancer de manière efficace, dans un cadre opérationnel classique, des attaques informatiques.

Le premier, nous l'évoquions récemment consiste à contrôler et à limiter strictement l'usage de la force aux seuls états et aux seules entités disposant d'une compétence et d'une autorité pour le faire. C'est donc éviter de manière absolue qu'un "fou" perturbe le déroulement des opérations militaires de LIO en faisant par exemple déraper le conflit.

Le second consisterait à déterminer une chaîne de commandement cohérente où les différents niveaux de commandement dispose d'une liberté d'action et de décision et où la LIO ne représente plus l'exception qu'elle continue souvent à être...Cette exception conduit à confier alors ces actions à des entités "exceptionnelles" que sont les services d'actions clandestine et de renseignement (NSA...). Cette interprétation est une représentation personnelle que je me fais de l'organisation militaire, à la lecture des brillants auteurs "mili" d'AGS. Elle ne peut prétendre à l'exactitude.

Selon un récent article, il semblerait que ce soit fait. Ainsi, toujours selon cet article, chaque commandement géographique (les UCC géographiques) serait bientôt autorisé à utiliser des détachements "LIO" pour appliquer de manière autonome des décisions en matière offensive et informatique. Des limites existent comme par exemple les frappes préemptives qui restent de la responsabilité du Président.

En toute logique, les SROE pour "Standing Rules of Engagement" ont été mises à jour, ce que suggère l'article. Le cadre ainsi créé répondrait de manière efficace à une normalisation de l'usage de la lutte informatique offensive et limiterait les cas "exceptionnels" à des situations bien particulières.

Le troisième projet fournit l'encadrement technique et la possibilité d'avoir un degré d'efficacité élevé et surtout susceptible de répondre aux missions et objectifs que pourrait avoir un commandement géographiques. Ex. : "Moi, chef du théâtre afghan, j'ai besoin que vous piratiez telle machine que le renseignement a identifié comme appartenant à un chef rebelle"...Fiction évidemment...

A en croire Wired, cet objectif serait atteint puisque le "Projet X" répondrait à ce besoins de rendre la conduite de la lutte informatique non plus du ressort de l'expert mais du "simple soldat". Toujours selon Wired, il s'agirait de rendre la "guerre informatique aussi facile qu'Angry Birds", le fameux jeu sur smartphone. Sans reprendre l'intégralité de l'article, le travail de Wired est comme souvent très documenté, les auteurs évoquent la création d'un langage spécifique qui serait aux attaques informatiques ce que le HTML est au Web.

Bien souvent évoqué, la mise en oeuvre d'un tel dispositif et de tels processus a longtemps paru impossible en raison de l'exception technique que pouvait constituer la LIO. Pour les Etats-Unis, une volonté de normalisation et d'encadrement a certes permis d'atteindre un résultat qui parait, sur le papier, capable de produire des effets d'ampleur. Cependant, entre le "papier" et la réalité, la mesure exacte de ses capacités doit être appréhendée avec prudence...pour ne pas se faire piéger par une forme de dissuasion de bon aloi !

Source :

Libellés :

Cyber-command,

Cyberwarfare - USA,

DARPA,

Défense,

DoD,

LIO - LID,

NSA,

ONU

lundi 27 mai 2013

Et si on s'était tous trompés ? Réflexions sur l'avenir de la "cyberguerre"

|

| Source :internetgovernance.org |

Le site "Internet Governance Project" est un observatoire de la gouvernance et de ses tendances. Y participent plusieurs acteurs dont l'implication dans les instances internationales de la gestion d'Internet ne sont pas ridicules.

Il est donc très souvent un lieu où l'on trouve des réflexions intéressantes et bien informées sur ces phénomènes. En témoigne un récent article relatant les réflexions d'un chercheur chinois, le Dr. He Baohong de l'académie de recherche en télécommunications. Celui-ci évoque ainsi la fragmentation de l'internet comme une "loi de l'histoire", un phénomène selon lui incontournable. A l'appui de son argumentation, il cite plusieurs références techniques bien sur mais également des questions de culture et de langage ou encore économiques.

Cette vision, sur laquelle je n'ai pas d'opinion ici, peut être rapprochée des analyses d'experts techniques, également blogueur qui évoquent les "middleboxes stupides qui infestent l'Internet" que Stéphane Bortzmeyer nomme régulièrement.

Prenons donc comme fait que l'Internet dés débuts ou "théorique" ne présente plus les mêmes caractéristiques. D'un réseau tout à fait décentralisé où les capacités de calculs étaient exportées aux extrémités et où le réseau était tout entier tourné vers le transport et la redondance , celui-ci a bien changé avec un retour à la centralisation (ex. cloud computing) et effectivement une forme de fragmentation croissante.

Or, les attaques informatiques et en particulier celles que l'on imagine liées à la "cyberguerre" ou que sais-je, se basent intrinsèquement sur la capacité à joindre la cible. Vrai ou faux ?

Partiellement vrai en fait comme l'aura très bien montré un exemple comme "Stuxnet" même si celui-ci constitue un cas bien particulier comparé à l'ensemble des codes malveillants que l'on trouve sur Internet.

La fragmentation de l'Internet peut alors être analysé comme la réponse aux faiblesses des systèmes d'informations, comme la volonté de limiter de manière drastique l'exposition aux attaquants potentiels. En cela, et l'on trouve trace dans un ouvrage récent "Menace sur nos libertés", la "militarisation" du cyberespace (concept délicat - j'en suis conscient) apparaît comme une potentielle menace sur l'avenir d'Internet...

Or, sans Internet, la "cyberguerre" n'est plus du tout la même chose et perd même une partie de sa substance.

Et si, à force de "cyberguerre", nous perdions l'ouverture, l'innovation et le développement qui ont permis Internet et sont nés du cyberespace ? Et si, à force de segmentation ou de fragmentation, nous finissions par perdre "Internet" ? Alors, n'aurions-nous pas perdu également la "cyberguerre" ?

Source :

Libellés :

Cyberwarfare,

Cyberwarfare - USA,

Défense,

Gouvernance Internet,

Stratégie

vendredi 24 mai 2013

Contrôler les miliciens : une difficulté à venir ?

|

| Source : CSIS.ORG |

A l'occasion d'une conférence organisée par le CSIS, l'intervention d'un des directeurs de la NSA donne un aperçu du problème des combattants électronique auto-proclamés.

Les propos tenus par Chris Inglis, directeur adjoint de la NSA évoque ainsi la crainte d'une multiplication d'une forme de représailles privées menées par des acteurs incontrôlés. Il est vrai que ce type d'acteur est facteur de chaos alors que les USA comme tant d'autres pays semble fournir beaucoup d'effort pour donner une cohérence forte à toutes les actions relevant de la LID ou LIO.

Le cas de "th3j35t3r" ou encore "the jester" pourrait entrer dans cette catégorie d'acteurs en raison de son important hacktivisme qu'il met au service de sa compréhension des causes américaines. Par exemple, en réalisant des dénis de service sur des sites "jihadistes" au sens large (organisation, propagandes, forums...) ou encore en "exposant" les identités réelles de certains pseudos.

Les raisons poussant la NSA à ne pas encourager le "vigilantism" (une pratique apparemment assez fréquente aux Etats-Unis consistant à assurer un service de sécurité public sans pourtant disposer de l'autorité ou de la légitimité adéquate pour le faire) tiennent notamment à un besoin de maîtrise.

M. Inglis ajoute d'ailleurs une phrase particulièrement percutante - que je traduis librement ici : "il est pratiquement impossible de s'assurer d'une position avantageuse continue dans le cyberespace dans un environnement en permanente évolution".

Cette vision se comprend d'autant mieux que selon lui, la dangereuse solution que serait ces pratiques de "guerriers privés" ne peut être retenue alors même qu'un récent rapport le préconiserait en réponse aux atteintes constantes que subiraient les entreprises chinoises en provenance de la Chine.

Un article réalisé par M. James Lewis du CSISC (source ci-dessous) fait également état de la dangerosité de ces pratiques et du crainte d'escalade qui y est liée. Il dresse également une liste de cas pratique où autoriser de type de démarche serait susceptible de causer du tort aux Etats-Unis. Ce faisant, par exemple, ils perdraient toute crédibilité dans leur insistance pour que la Russie et la Chine soient plus offensifs vis-à-vis des organisations qui profitent d'une certaine tolérance pour conduire des activités criminelles ou d'espionnage sur Internet.

Cette problématique de la gestion des actes offensifs privés sur Internet est intéressante pour 3 raisons. D'une part, elle n'est pas sans lien avec la privatisation de la guerre que la thématique "Société militaires privées" représente assez bien. Il semble pourtant que les autorités américaines ne s'y résolvent pas, ce qui indique assez la sensibilité et la complexité des problématiques de lutte informatique.

D'autre part, cette problématique ne semble pas encore être apparue chez nous. Bien sur, ne pas la connaître ne signifie pas que quelqu'un ne l'a pas traitée. Cela ne veut pas dire non plus qu'elle n'existe pas mais sans doute qu'elle occupe encore peu le débat. En effet, la nature même d'Internet rend ce type d'actions à la fois très probable mais aussi relativement aisé.

Enfin, les craintes exprimées aux Etats-Unis ne sont pas nécessairement les nôtres. La thématique du "super héros" solitaire aux choix moraux complexes est un thème fréquent dans les films et séries. La lecture du dernier article consacré au Jester et le peignant comme un héros le montre assez bien.

Ces quelques lectures éclairent donc un problème pour le moment perçu essentiellement outre-atlantique. Il n'est pas avéré qu'il doive faire l'objet d'une inquiétude au même titre en France mais se poser une question n'a jamais amené qu'à plus de connaissance...

Source :

Libellés :

Cyberwarfare,

Cyberwarfare - USA,

Hacktivisme,

LIO - LID,

Stratégie

jeudi 23 mai 2013

La sécurité de l'information est-elle un échec ? Suite de la série d'article...

|

| Source AGS |

Dans la continuité de notre série d'article relatif à la SSI, vous trouverez ci-dessous le lien vers la dernière publication :

Dans cet article, l'objectif est d'évaluer quelques propositions pour faire évoluer positivement le niveau SSI par le biais économique.

Le prochain article devrait constituer le dernier de la série et proposer une synthèse des différentes mesures proposées.

Source : dans le texte

Libellés :

AGS,

Sécurité - Organisationnelle,

Sécurité - Technique

jeudi 16 mai 2013

Sécurité et mode de développement : vers une évolution systémique ?

|

| Source : hthemyndset.com |

Dans plusieurs messages antérieurs, nous évoquions la sécurité sous l'aspect du développement et de la production de logiciels ou de systèmes d'exploitations moins vulnérables. Quelques signaux faibles permettaient alors d'entrevoir une évolution positive de cet écosystème sans que puisse être matérialisée une tendance.

Il serait pourtant possible que celle-ci se soit matérialisée comme en témoigne une récente étude auquel vous pardonnerez l'auteur de ce blog d'essayer d'en dégager une vision plus globale (on ne se "refait" pas).

Cette étude a été conduite par Coverity, une société lancée en 2006 avec la bénédiction du DHS - Department of Homeland Security - américain et propose un service de vérification automatique (scan) des erreurs de développement. Le partenariat qui a permis de lancer le service se serait terminé en 2009.

Quelques précisions qui paraissent importantes : la vérification d'un code est un exercice complexe et dont l'automatisation n'est pas toujours possible. Ainsi, non seulement la société précise les limites de son action en indiquant se concentrer sur une analyse statique (et non dynamique) qui ne révèle pas nécessairement tous les aspects de l'exécution d'un code. Elle livre également une liste non-limitative des erreurs que son service est capable de déceler.

Pour autant, un tel produit aurait-il pu déceler une faille à priori complexe comme celle relative au noyau Linux qui fait l'actualité ? Cela n'est pas si sur et si le processus était automatisable si facilement, le marché des 0-day présenterait sans doute moins d'intérêt.

En se basant sur ces réflexions, j'ai tendance à croire que ce type d'outil fournit une bonne détection de premier niveau. En outre et surtout, elle constitue un excellent indicateur de la qualité générale d'un code. Le rapport publié par Coverity semble ainsi révéler une tendance de qualité croissante notamment dans le monde de l'open source. Celle-ci semblerait se manifester de manière plus perceptible depuis deux ans.

Pour appuyer ses dires, l'article se concentre sur un indicateur : le nombre d'erreurs de code conduisant à des défauts pour 1000 lignes de codes. Il note globalement une amélioration que le code soit d'origine "open source" ou "professionnel" avec des tendances inférieurs à 1, ce qui constitue une évolution en soi.

Cependant, si le code "pro" ou "open" semble avoir un taux de défaut proche (0,68 et 0,69) dans l'ensemble, on distingue deux tendances. Si sur des "petits" programme inférieur à 1 millions de lignes de code, l'open source semble de meilleur qualité, la tendance semble s'inverser sur des programmes plus lourds. L'évolution est étrange cependant car sur la "gamme" de code compris entre 500 000 et 1 million de lignes, le taux d'erreur "open" est très bas (0,44), le code professionnel est plutôt mauvais (0,98).

A cela s'ajoute la spécificité de Linux dont la société a analysé plus de 7 millions de lignes de code sur la version 3.8 pour une densité de défaut de 0,59 soit inférieure à la moyenne observée. On aimerait connaître l'analyse pour Windows mais il faudrait disposer du code source. A noter qu'en ce qui concerne le Kernel Linux, le taux est plus élevé avec une augmentation drastique de la qualité sur simplement un an : 0.95 en 2011 et 0.76 en 2012 !

Il semble donc que la qualité du logiciel devienne finalement à la fois rentable mais également une caractéristique recherchée. Par ailleurs, et c'est une forme de preuve intéressante, l'open-source semble désormais une référence incontournable en la matière ! Cela pourrait donc inciter certains organisations à ré-orienter leurs modèles d'achat informatique en ne se contentant plus d'acheter des logiciels sur étagères mais plutôt en consacrant des ressources au développement et à la qualité - donc la sécurité - des logiciels qui les intéressent...

C'est aussi très certainement une information intéressante dans le monde de la sécurité qui déplore parfois une certaine stagnation...peut-être à lier à la médiatisation croissante des attaques. Signaux faibles et tendance vous disais-je !

Source :

Libellés :

DHS,

Sécurité - Organisationnelle,

Sécurité - Technique

dimanche 12 mai 2013

jeudi 2 mai 2013

Chronique d'une attaque ordinaire...

|

| Source : Wikipedia |

Il faudrait parler de Livre Blanc...Il le faudrait vraiment mais l'humeur du moment est décidément technique, au moins en ce qui me concerne. C'est donc de cela que je vais vous parler puisque lors j'ai eu téléchargé le "pdf" du LBDSN, la première chose que j'ai faite, c'est de transformer le pdf en texte (pdftotext) puis de "faire un grep" sur le motif "cyber" et de le compter...J'ai trouvé 37 occurrences du terme, souvent associés avec d'autres suffixes comme "défense", "attaque" ou encore "espace". A titre de comparaison, "nucléaire" est présent 69 fois et NRBC 6 fois...

Toutefois, l'humeur du jour me pousse plutôt à vous évoquer le quotidien des attaques "ordinaires" et les problèmes qui se posent aux administrateurs et responsables sécurité. Sans forfanterie j'espère, mon cas personnel me semble fournir matière à réflexion. En effet, je suis client et titulaire d'un serveur disponible sur Internet et suis régulièrement confronté à des questions de sécurité...

L'utilité de ce serveur est essentiellement de procurer des services réseaux, notamment des tunnels, que je peux facilement utiliser à partir d'une connexion non connue et donc potentiellement dangereuse. Entre autres...Pour compliquer l'affaire, il s'agit d'un serveur virtualisé qu'une petite société loue en louant elle-même des serveurs physiques à une seconde, et plus grande, entreprise.

Considérant mes intérêts, je me suis intéressé à la sécurité du serveur...Bien que j'ai oublié de le préciser, le serveur fonctionne sous Linux Debian et la lecture du manuel est très utile. Parmi plusieurs réglages, l'exposition du serveur a été limité par l'usage d'un firewall, les protocoles d'administration à distance ont été limités. J'ai également mis en oeuvre quelques outils afin d'obtenir une meilleure visibilité sur le danger qu'un serveur court sur Internet...et puis pour s'amuser avec les logs.

Ainsi, un outil automatique d'exclusion a été installé ainsi qu'un système de détection d'intrusion ou encore un antivirus....Puis j'ai installé mes outils réseaux avant de laisser vivre un peu le serveur. Régulièrement, je m'y connecte pour le mettre à jour et surtout m'intéresser aux logs...

On en retire plusieurs leçons...

D'une part, sur un serveur lambda présentant des caractéristiques génériques - comme l'usage d'un port d'administration classique - le taux de scan est véritablement affolant. Je m'intéresse ainsi aux tentatives de connexions ratées puis réussies ou encore aux informations remontées par les outils de détection ou de prévention d'intrusion. Par exemple, sur 5 jours, il est possible de constater plus de 2000 tentatives échouées de connexion...

Les adresses IP ayant émises ces connexions sont d'ailleurs au final peu nombreuses et sont identifiées comme appartenant à des entités russes ou chinoises (sic...). Si l'on s'amuse un peu, on remarque ensuite que les tentatives de connexion se font par paquets d'environ une petite centaine de tentatives à chaque heure de la journée. Cela fait songer au comportement automatisé d'un outil quelconque.

Toutefois, la recherche de ces informations n'est pas nécessairement intéressantes mais elle permet parfois de se rendre compte de certaines limites : par exemple, le comportement d'une des adresses est tel que une ou deux minutes se passent entre plusieurs tentatives. Cela déjoue donc mon système et c'est pourquoi le système d'exclusion n'est pas efficace en l'état.

D'autre part, la lecture et l'analyse de ces logs n'est pas évidente. Pour être franc et puisque ce n'est pas une action que je réalise chaque jour - la plupart du temps, les vérifications sont moins poussées - il serait difficile de tout détecter. Rappelez-vous qu'un fichier log est une succession de lignes contenant des informations "techniques" : il faut donc l'analyser intelligemment pour en tirer quelque chose !

De plus, dans mon cas, la quantité de logs est raisonnable et ce que je recherche est relativement simple. Imaginez alors des équipements concernant une organisation de taille importante (et son trafic quotidien) et l'importance des journaux d'évènements ! Il est alors nécessaire de disposer d'outils efficaces et d'une équipe aguerrie et bien formée surtout si l'on cherche à comprendre les ressorts d'une attaque.

Cette chronique d'une attaque ordinaire permet donc de comprendre que non seulement l'Internet est un milieu agressif mais que le paisible internaute ne le voit guère. D'autre part, il est facile de ne pas détecter l'attaque et de passer à côté de l'élément intéressant !

Ceci nous amène à conclure qu'en matière de lutte informatique, la "matière grise" est aussi importante que les bons outils et que les problématiques sont complexes...Au final, nous ne sommes pas si loin du Livre Blanc...

Source : dans le texte

Libellés :

Sécurité - Organisationnelle,

Sécurité - Technique

mercredi 17 avril 2013

mardi 16 avril 2013

Des signaux faibles ?

|

| Source : emoveo.fr |

Le récit par Mme Loquet de ses aventures à Cansecwest 2013 a fourni matière à réflexion. En effet, alors qu'elle nous relate le déroulement des conférences et des moments festifs, l'interview du patron de Vupen, Chaouki Bekrar constitue le point de départ de la réflexion.

Relativement discret, celui-ci évoque néanmoins les réussites de sa société et de ses équipes de chercheurs en sécurité. Pour mémoire, la société Vupen fait commerce des vulnérabilités qu'elle peut déceler dans des produits, souvent grands publics, et logiciels. Elle s'est notamment illustrée pour avoir été une des première à "faire tomber" le navigateur de Google (chrome).

Car, en effet, la conférence est également l'occasion du concours Pwn2own qui permet aux participants de démontrer la vulnérabilité de certains logiciels très connus comme Chrome, Internet Explorer, Flash, Windows...

Les propos de M. Bekrar sont à retenir car selon lui, la sécurité de ces logiciels est croissante et nécessite un investissement en temps et en recherche important. Nous évoquions ici la problématique de la sécurité des logiciels et du développement.

La lecture du blog cybergeopolitk révèle également des budgets importants consacrés aux problématiques de sécurité et de lutte informatique par les Etats-Unis alors même qu'ils connaissent d'importants soucis budgétaires. Cette tendance se traduit aussi dans la multiplications des annonces, des partenariats et des démarches en matière "cyber".

En bref, peut-on assister à une modification dans le milieu de la sécurité ? Pourrait-on imaginer, à l'instar de la transition démographique que la SSI commence à évoluer vers une sécurité accrue en même temps que la médiatisation des problèmes augmentent ?

Remplaçons alors taux de natalité par le niveau de défaillance SSI et la population totale par le niveau de médiatisation...Nous entrerions alors dans une phase 1 où la médiatisation et la prise en compte se renforcent de manière très importante. Se produit alors, tant bien que mal, une élévation globale du niveau de sécurité.

Bien sur, cette analogie ne tient pas très longtemps : elle ne fait qu'illustrer très simplement une transition intéressante. Notez aussi que la prise en compte croissante de la SSI dans certaines sociétés, par ailleurs très évolué technologiquement ne garantit pas que la majeure partie des organisations saura en tirer profit.

Il reste donc, très certainement, de beaux jours à la SSI et plus encore à la LID. Rien n'empêche cependant de se poser parfois la question de la pertinence d'un signal...même très faible.

Source :

dans le texte

Libellés :

Sécurité - Organisationnelle,

Sécurité - Technique

Inscription à :

Articles (Atom)