Un article de M. Mueller, observateur avisé des phénomènes de la gouvernance Internet a relancé le débat sur le routage.

Si votre mémoire est, comme la mienne, occupée par une myriade de détails quotidiens, il est parfois délicat de se rappeler de l'ensemble des éléments. Récapitulons donc rapidement !

Le routage sur Internet est la capacité nécessaire pour amener des paquets au sens réseau d'une machine à une autre suivant les réseaux et la connectivité disponible. Parmi les nombreuses solutions techniques disponibles, un protocole en particulier est utilisé pour les échanges au niveau des opérateurs majeurs - ex. entre Orange et Free ou Orange et Cogent. Ce protocole est connu pour présenter des problématiques de confiance ayant occasionné plusieurs incidents (détournement par "la Chine" par exemple).

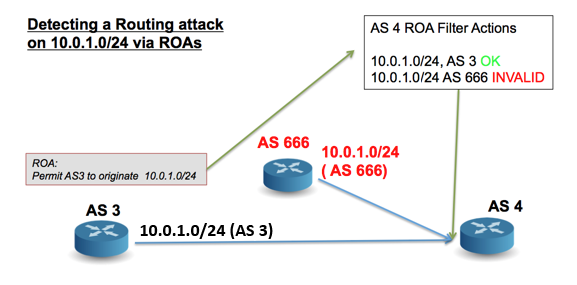

Rappelons également le principe suivant : lorsque vous souhaitez joindre un site, celui-ci sera identifiée par une adresse IP pour votre ordinateur. Pour permettre de déterminer la "localisation" (au sens technique) de la machine, les fournisseurs "publient" au sein de leurs routeurs des informations sur les ensembles d'adresses qu'ils détiennent. Ces informations sont alors transmises de routeurs en routeurs, ce qui permet à ces machines de déterminer les meilleurs chemins pour y arriver.

Le problème est le suivant : comment s'assurer que l'opérateur qui prétend détenir la machine identifiée par l'adresse que vous souhaitez atteindre dit vrai ? Et comment s'assurer que vous passez par le bon chemin ?

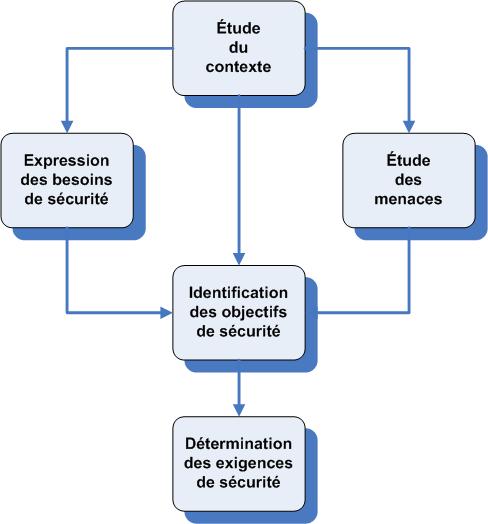

Ce double problème a nécessité deux traitements distincts s'appuyant toute deux sur des solutions cryptographiques et une infrastructure de clé, la RKPI. Si le premier problème - authentifier la source - a relativement rapidement débouché sur une solution, s'assurer du chemin suivi demeure encore un problème complexe.

Parallèlement sont apparues des solutions alternatives comme Rover qui utiliserait le DNS et notamment DNSSEC. Cela permettrait de limiter l'utilisation des ressources au niveau des routeurs tout en apportant les informations nécessaire permettant de vérifier que le prétendu détenteur est bien légitime !

Trois problèmes sont alors apparus dans le développement de cette solution :

- d'une part, cela crée un système centralisé et hiérarchique dans des opérations qui jusqu'ici étaient encore très décentralisées et permettait une certaine souplesse. Or, il semble que cette souplesse demeure essentiel non seulement dans le fonctionnement des fournisseurs de services mais aussi pour les usagers.

Dans le premier cas, il s'agit de pouvoir choisir les clients, les vendeurs ou les égaux : ceux que l'on "transporte", ceux à qui l'on demande de transporter et ceux avec qui on échange...du trafic. Mais c'est également un facteur de solidité puisque la possibilité de modifier le trafic facilement permet aussi de pallier à des défaillances localisées (ex. rupture de câble) ;

- d'autre part, des voix discordantes sont apparues pour dénoncer un système d'une lourdeur exceptionnelle illustrant leurs propos par des estimations, jugées crédibles, sur le temps d'acquisition des informations nécessaires par les machines (plusieurs jours et jusqu'à un mois) ;

- cela illustre également un processus de décision et de création des standards qui semblent ici mis en déroute par les intérêts liés à cette problématique. On pourra s'étonner que le caractère déraisonné de la solution proviennent d'analyses faites par le secteur privé et ne reposant pas uniquement sur des critères financiers. Une recherche de qualité de service semble ainsi demeurer au sein des organisations.

Tout cela sans mentionner directement le fait que la centralisation des opérations de contrôles du routage offre une facilité de surveillance à des gouvernements peu scrupuleux.

En conclusion, plusieurs questions apparaissent sur l'avenir du routage et de son infrastructure. Quel est le degré de sécurité attendu ? Est-on prêt aux conséquences que les tendances actuelles laissent présager ? Comment dépasser les intérêts quelques peu corporatistes pour une solution efficace sur le long-terme et équilibré dans ses contraintes ?

Source :